大數據課程優勢

大數據課程優勢 國內人才缺口

行業需求增長

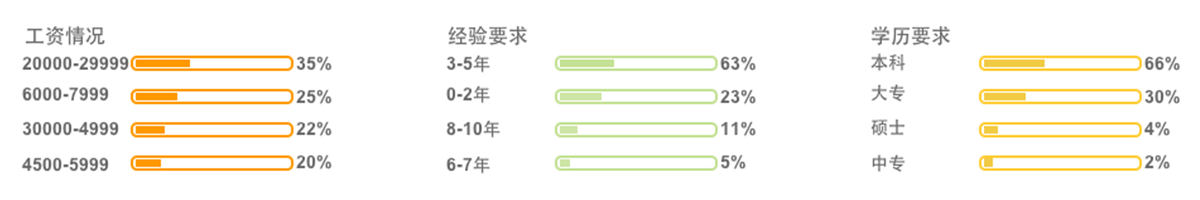

獵聘網大數據招聘

北京大數據工程師

| 01 大數據入門基礎課程 | 1.JavaSE;2.MySQL;3.JDBC;4.Linux;5.shell;6.HTML;7.CSS;8.JavaScript;9.JSP;10.Servlet |

| 02 大數據Hadoop基礎 | 1.大數據概論;2.Hadoop框架;3.HDFS分布式文件系統;4.MapReduce計算模型;5.全真實訓項目 |

| 03 大數據離線分析 | 1.Hive數據倉庫;2.Sqoop ETL工具;3.Azkaban工作流引擎;4.Ooize;5.Impala;6.全真實訓項目 |

| 04 大數據實時計算 | 1.Zookeeper分布式協調系統;2.HBase分布式數據庫;3.Redis數據庫;4.mogDB數據庫;5.Kudu列式存儲系統;6.Storm實時數據處理平臺;7.Kafka分布式發布訂閱消息系統;8.Flume海量日志采集系統;9.全真實訓綜合項目 |

| 05 Spark數據計算 | 1.Scala;2.Spark;3RDD;4.Spark SQL;5. Streaming;6. Mahout;7.MLlib;8.GraphX;9.Spark R;10.Python;11.Alluxio;12.Python爬蟲;13.ElasticSearch;14.Lucene |

| Hadoop基礎實戰 |

項目名稱:搜狗搜索日志分析系統 數據體量:5000W+/日 硬件環境:Hadoop集群 12臺 軟件環境:Hadoop2.5.2+Hive1.2.1+MR+Oracle10g 項目描述:搜狗每天產生大量的日志數據,從日志數據里面能提取到有用的數據包括每個用戶的ID、瀏覽次數、月/日瀏覽頻率、訪問源、瀏覽內容等等,提取這些內容、統計數據分析每個用戶行為,從而做出有利的決定。 |

| 大數據離線實戰 |

項目名稱:新浪微博數據分析系統 日均數據體量:3GB+ 硬件環境:Hadoop集群 50臺 軟件環境:MapReduce+HBase0.98.9+Storm0.9.6+Hadoop2.5.2+Kafka2.10+Zooke eper3.4.5+CentOS-6.5-X86 項目描述:此次項目我們需要處理微博產生的數據,通過對數據的處理得到所需的數據,微博擁有大量的用戶,大量的用戶潛在的價值是巨大,怎么挖掘這些潛在的寶藏就是我們項目最直接的目的,為了能夠實時的進行數據處理使用Storm流式計算系統,和HBase、Zookeeper、Kafka組成框架,對數據進行處理,當然這些都是建立在hadoop集群上實現的,底層的存儲還是HDFS。 |

| 大數據實時計算 |

項目名稱:網絡流量流向異常賬號統計項目 數據體量:每天1000億,每秒峰值100 000 硬件環境:Hadoop集群 600臺 軟件環境:Hadoop2.5.2+Hive1.2.1+MR+Oracle10g 項目描述:運營商骨干網上采集現網流量流向信息,根據這些原始信息檢測賬號是否存在異常,如果多個終端使用同一個寬帶賬號,超過一定閾值則觸發報警機制,例如閾值為5時,同一個賬號同時連接的終端數量不能超過該值,如果超過則報警。 |

| Spark階段項目 |

項目名稱:京東網上商城數據統計分析平臺 數據體量:5000W+/日 硬件環境:centos-6.5-x86 集群:spark standalone(Master-1,Worker-3) 軟件環境:hadoop,spark,hive,mysql,idea,navicat,kafka,flume 每日處理的數據量:3GB 項目描述:基于京東網上商城數據統計分析平臺--該項目采用了目前大數據領域非常流行的技術——Spark。本項目使用了Spark技術生態棧中最常用的三個技術框架,Spark Core、Spark SQL和Spark Streaming,進行離線計算和實時計算業務模塊的開發。實現了包括:統計和分析UV、PV、登錄、留存、熱門商品離線統計、廣告流量實時統計3個業務模塊。 |

梁建全

梁建全畢業于北京大學,12年以上JAVA企業項目架構和開發經驗。曾在二炮科技處、UPS科技、日本UCI科技等多家知名企業擔任過項目經理和研發總監。

趙強

趙強畢業于清華大學,13年以上開發經驗。先后就職于IBM、摩托羅拉、甲骨文,現任Oracle公司高級技術顧問,精通Oracle數據庫和大數據Hadoop的管理和開發。

講師、項目經理均為專職,培養體系嚴謹、實 用;講師,學員打分體系,講師好不好你 說了算!

變態嚴管,讓你破繭成蝶。“變態”的學習訓 練,因為愛你,所以嚴厲,我們要培養的是IT 特種兵。

授之以魚更授之以漁。濟南兄弟連創始人李超老師, 也會親自授課,分享自己三十幾年的人生經歷 和經驗。

課上采用案例式教學,通俗易懂,課下項目經理 一對一輔導強化訓練,學與練交叉進行強化記憶, 你要做的就是認真聽,勤于問,樂于練。

濟南兄弟連一直堅持人手一機,學員可以隨時在教 室學習,無論晚上11點還是凌晨4點,你都將 看到為自己的理想而埋頭苦學的兄弟姐妹。

學不會,免費重修;找工作,免費 力薦。畢業后,你會發現python開發工程師的圈 子里到處是你的人脈,讓你在職場更加如虎添翼。

|

|

|

|

|

|

|

|

濟南大數據培訓中心課程大綱

- 提升您的數據處理能力

課程背景

- 大數據時代的需要

隨著數字化的步伐不斷加快,大數據已經成為當今世界最熱門的名詞之一。對于企業來說,大數據意味著機會和挑戰。許多企業已經開始將大數據應用到自己的業務中,但同時也需要人才來處理這些海量的數據。在這種情況下,濟南大數據培訓中心應運而生,旨在為大數據行業輸送優秀的數據專業人才。

課程特色

- 全方位深入學習

1.實踐性強:本課程強調學以致用,在學習過程中,充分利用真實數據進行案例分析和實踐操作,讓學員在熟練掌握數據處理技能的同時,也能盡早適應工作。

2.課程體系完整:課程包括大數據基礎、常用大型數據庫、Hadoop、Spark、Python爬蟲、數據挖掘等內容,滿足從零基礎到進階學習各階段的要求。

3.師資強大:我們的教師來自于知名企業,業內著名專家和學者,擁有多年實戰經驗和豐富的教學經驗。

4.定制化課程:針對企業需求,我們可以針對具體場景制定個性化培訓計劃。

課程目標

- 提升學員數據處理能力

1.培養學員對大數據處理的興趣和熱情。

2.熟練掌握Hadoop、Spark等大數據處理工具的使用。

3.掌握常見數據庫的使用,提高學員對數據庫的管理和維護的能力。

4.了解數據挖掘和機器學習等技術。

學習對象

-數據處理愛好者、數據分析師、數據產品經理等

1.初學者:想了解大數據的好奇心驅使下,迫切希望了解大數據處理的基礎知識。

2.數據分析師:希望學習Hadoop、Spark和Python爬蟲等工具,提高自己的數據分析能力。

3.數據產品經理:希望通過學習大數據處理技術,加深對數據需求的理解和理性分析能力,提高設計和規劃數據產品的能力。

課程內容

- 系統學習大數據處理技術

1.大數據基礎:了解大數據概念、特點和基本架構。

2.常用數據庫:掌握MySQL、Oracle和NoSQL等數據庫的使用和管理。

3.Hadoop:學習Hadoop基礎架構以及MapReduce等相關處理技術。

4.Spark:了解Spark原理、特點和基礎API的使用。

5.Python爬蟲:學習Python語言基礎、爬蟲基礎知識以及爬蟲實戰操作。

6.數據挖掘:了解并掌握數據挖掘和機器學習等技術。

學習時長

- 根據課程設置而定

我們的課程時間靈活,可以根據個人需求和企業要求進行定制化學習計劃。

收費范圍

- 合理定價,提供多種選擇

我們提供不同級別的課程,從基礎到進階全面覆蓋,收費范圍根據不同的課程難度和時長有所區別。同時我們也有折扣和優惠政策,旨在滿足不同學員需求。

學習收獲

- 擴展您的就業機會

本課程旨在提升學員在數據處理、數據分析、大數據技術等方面的技能水平,幫助學員得到更多的就業機會和發展空間。同時,我們也提供就業指導和實習機會,讓學員能夠更好地將所學知識應用到實際工作中。

結語

- 歡迎聯系我們獲取更多信息

以上信息僅供參考,實際情況以到校咨詢為準。可聯系在線客服,預約免費體驗課。如果您想了解更多關于我們課程的信息和學習方案,請隨時與我們聯系。我們將竭誠為您服務。

¥詢價2236人關注

¥詢價2941人關注

¥詢價1894人關注

¥詢價2276人關注

¥詢價1088人關注

¥詢價1080人關注