大數據課程優勢

大數據課程優勢 國內人才缺口

行業需求增長

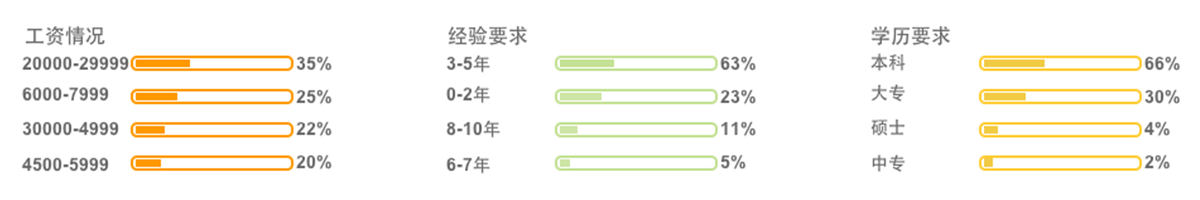

獵聘網大數據招聘

北京大數據工程師

| 01 大數據入門基礎課程 | 1.JavaSE;2.MySQL;3.JDBC;4.Linux;5.shell;6.HTML;7.CSS;8.JavaScript;9.JSP;10.Servlet |

| 02 大數據Hadoop基礎 | 1.大數據概論;2.Hadoop框架;3.HDFS分布式文件系統;4.MapReduce計算模型;5.全真實訓項目 |

| 03 大數據離線分析 | 1.Hive數據倉庫;2.Sqoop ETL工具;3.Azkaban工作流引擎;4.Ooize;5.Impala;6.全真實訓項目 |

| 04 大數據實時計算 | 1.Zookeeper分布式協調系統;2.HBase分布式數據庫;3.Redis數據庫;4.mogDB數據庫;5.Kudu列式存儲系統;6.Storm實時數據處理平臺;7.Kafka分布式發布訂閱消息系統;8.Flume海量日志采集系統;9.全真實訓綜合項目 |

| 05 Spark數據計算 | 1.Scala;2.Spark;3RDD;4.Spark SQL;5. Streaming;6. Mahout;7.MLlib;8.GraphX;9.Spark R;10.Python;11.Alluxio;12.Python爬蟲;13.ElasticSearch;14.Lucene |

| Hadoop基礎實戰 |

項目名稱:搜狗搜索日志分析系統 數據體量:5000W+/日 硬件環境:Hadoop集群 12臺 軟件環境:Hadoop2.5.2+Hive1.2.1+MR+Oracle10g 項目描述:搜狗每天產生大量的日志數據,從日志數據里面能提取到有用的數據包括每個用戶的ID、瀏覽次數、月/日瀏覽頻率、訪問源、瀏覽內容等等,提取這些內容、統計數據分析每個用戶行為,從而做出有利的決定。 |

| 大數據離線實戰 |

項目名稱:新浪微博數據分析系統 日均數據體量:3GB+ 硬件環境:Hadoop集群 50臺 軟件環境:MapReduce+HBase0.98.9+Storm0.9.6+Hadoop2.5.2+Kafka2.10+Zooke eper3.4.5+CentOS-6.5-X86 項目描述:此次項目我們需要處理微博產生的數據,通過對數據的處理得到所需的數據,微博擁有大量的用戶,大量的用戶潛在的價值是巨大,怎么挖掘這些潛在的寶藏就是我們項目最直接的目的,為了能夠實時的進行數據處理使用Storm流式計算系統,和HBase、Zookeeper、Kafka組成框架,對數據進行處理,當然這些都是建立在hadoop集群上實現的,底層的存儲還是HDFS。 |

| 大數據實時計算 |

項目名稱:網絡流量流向異常賬號統計項目 數據體量:每天1000億,每秒峰值100 000 硬件環境:Hadoop集群 600臺 軟件環境:Hadoop2.5.2+Hive1.2.1+MR+Oracle10g 項目描述:運營商骨干網上采集現網流量流向信息,根據這些原始信息檢測賬號是否存在異常,如果多個終端使用同一個寬帶賬號,超過一定閾值則觸發報警機制,例如閾值為5時,同一個賬號同時連接的終端數量不能超過該值,如果超過則報警。 |

| Spark階段項目 |

項目名稱:京東網上商城數據統計分析平臺 數據體量:5000W+/日 硬件環境:centos-6.5-x86 集群:spark standalone(Master-1,Worker-3) 軟件環境:hadoop,spark,hive,mysql,idea,navicat,kafka,flume 每日處理的數據量:3GB 項目描述:基于京東網上商城數據統計分析平臺--該項目采用了目前大數據領域非常流行的技術——Spark。本項目使用了Spark技術生態棧中最常用的三個技術框架,Spark Core、Spark SQL和Spark Streaming,進行離線計算和實時計算業務模塊的開發。實現了包括:統計和分析UV、PV、登錄、留存、熱門商品離線統計、廣告流量實時統計3個業務模塊。 |

張立猛

張立猛北航軟件工程碩士,16年軟件架構開發經驗,曾就職于東軟、DNS等知名企業,新東方、達內前教學總監,精通JAVAEE、JAVA框架、Oracle數據庫,知名企業培訓大咖。

楊力

楊力原普開數據大數據架構師兼教學總監,新奧集團公司云數據平臺項目首席架構師,京東萬象大數據平臺締造人之一,二六三網絡通信反垃圾郵件系統平臺項目經理。

中途耽誤幾天的話可以通過看視頻同步完成老師的作業彌補進度,不會的可以隨時問老師。

學生因學習中途落課或者學習效果不扎實等原因可以向教務老師申請重修或降級,本期學不會下期免費再學,直到學會為止!

學習的流程分為預習、聽課、整理筆記、作業(每周定期檢查作業,并針對反饋情況進行講解)、復習、默寫、項目階段跟蹤檢查。

預習筆記是兄弟連一再強調的學習法寶,每個同學在兄弟連都必須養成課前預習的習慣,對老師第二天要講授的內容重點、難點做到心里有數,聽課事半功倍。

開課后根據學生的作業及測驗情況形成關懷名單,進入關懷名單的學生會被所有老師所關注,相應的對其作業、預習筆記、默寫等要求會更高,要求會更嚴格。

學習中遇到問題,小組成員共同討論解決,小組內有學習懈怠完不成學習任務的同學,小組內全體成員會集體被罰(罰手抄代碼n遍喲)。

|

|

|

|

|

|

|

|

課程背景

大數據已經成為了當前發展趨勢,對于企業管理和決策來說,利用大數據進行分析已經成為了一項必不可少的技能。因此,大數據周末培訓班應運而生,為廣大學習者提供了一個系統、全面的學習平臺。

課程特色

1. 課程內容全面,知識點詳細,涵蓋了大數據生態系統各方面的知識點。

2. 課程設置案例分析和實踐課程,幫助學習者快速掌握實際應用技能。

3. 課程采用授課+案例演示的教學模式,既保證了知識性,也保證了趣味性和實用性。

課程目標

1. 了解大數據概念和意義,學會基礎理論知識和分析方法。

2. 掌握大數據處理、存儲、分析和可視化工具的使用方法。

3. 能夠熟練掌握大數據分析、處理及應用技巧,并能在實際工作中靈活應用。

學習對象

1. 企業技術人員,需要了解大數據技術的基礎知識和應用方法的人員。

2. 需要進行大數據分析和處理的從業人員。

3. 對于計算機、數據處理等技術知識有一定基礎并希望進一步提升技能水平的人員。

課程內容

1. 大數據概念和應用場景的介紹。

2. Hadoop分布式文件系統、HDFS文件操作及文件存儲的原理。

3. Hadoop數據處理技術,包括MapReduce、Pig和Hive的使用。

4. 實戰案例分析,例如基于Hadoop的數據處理及可視化案例。

5. 大數據處理常用工具的介紹和使用方法。

學習時長

本周末培訓班為期兩天,共16小時。

收費范圍

根據不同地區和課程內容的難度程度,收費有所不同。請咨詢在線客服進行了解。

學習收獲

1. 理論知識儲備更加豐富,能夠掌握大數據的基礎概念和相關理論知識。

2. 能夠掌握大數據處理、分析及應用方法,做出相應的數據統計和分析報告。

3. 了解大數據應用技術的具體操作流程及工具使用,提升了實用技能。

結語

以上信息僅供參考,實際情況以到校咨詢為準。可聯系在線客服,預約免費體驗課,大家可以通過免費試聽環節全方位地了解我們課程的具體內容和學習過程,并且可以稱作聚會一批志同道合的小伙伴,共同學習,共同進步。

¥詢價19779人關注

¥詢價28729人關注

¥詢價29099人關注

¥詢價18347人關注

¥詢價23137人關注

¥詢價15224人關注

¥詢價11943人關注

¥詢價14846人關注